2023. 11. 2. 11:49ㆍ카테고리 없음

오늘은 NOCS DATASET을 분석하여 정리해보고자한다.

NOCS DATASET은 Category-level pose estimation 을 하기 위한 Dataset이라 할 수 있다. Instance level 6D pose estimation 에서와는 달리 훈련 또는 Test 에 정확한 개체 CAD 모델을 사용할 수 없다고 가정한다.

Instance level 6D pose estimation 의 최근 연구동향으로는 template matching 방식 또는 object coordinates regression 방식으로 나뉜다. 탬플릿 매칭 기법은 3D CAD 모델을 촬영한 3D point cloud 데이터에 반복적으로 모든 점을 알고리즘으로 정렬하는 방식으로 진행된다. 객체 좌표 회귀 방법은 각각의 물체 pixel에 대응하는 객체 표면위치를 회귀시키는것을 목표로 하는 방식이다. 따라서 위 두방식은 정확한 3D model을 필요로 한다.

NOCS 공간은 6D pose 와 size estimation을 가능하게하고 훈련에 없었던 object 객체들도 예측이 가능하다.

이 방법의 핵심은 object class와 instance mask 그리고 단일 RGB 이미지로 부터 여러 물체의 Nocs map 을 공동으로 예측하는 CNN 네트워크에 있다. NOCS 맵은 객체 픽셀과 Nocs간의 밀집된 대응관계를 예측하여 객체의 visible part의 정규화된 모양을 캡쳐한다. CNN 네트워크는 pixel regression 또는 classifictaion 문제로 공식화 하여 추정한다. 그런다음 마지막으로 NOCS map을 depth map 정보와 결합하여 회귀 방식으로 객체의 6D pose를 에측한다. depth map은 CNN 네크워크에서는 활용되지 않는다. 네트워크에서는 class, instance mask, nocs map만 예측한다. 네트워크는 Mask R-CNN 프레임워크를 기초로 하여 NOCS 를 함께 추론한다. 전체 네트워크는 아래 그림과 같다.

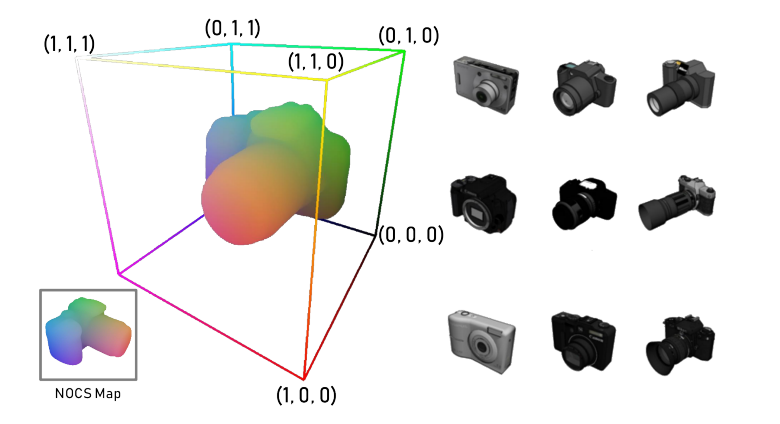

NOCS 는 unit cube 내에 포함된 3D 공간으로 정의된다. {x, y, z} ∈ [0, 1]

각 카테고리의 Obejct CAD 모델의 형상이 주어졌을때 bounding box의 대각선 길이가 1이고 중심이 NOCS Space에 존재하도록 객체를 균일하게 스캐일링하여 크기를 정규화 시킨다. 또한 객체 중심과 방향을 동일한 category 에 걸쳐 일관된 방향으로 정렬한다. 위 논문에서는 scale, position, 방향에 대해 이미 표준화 되어있는 ShapeNetCore 모델을 사용한다.

따라서 CNN 네트워크는 NOCS 좌표의 Color-coded의 2D perspective 투영맵을 예측한다.

결론적으로 위 논문에서 하고자했던것은 NOCS map과 depth map을 가지고 물체의 6D pose를 구하려 했던것이다. 이를위해 color 이미지에 depth 이미지를 정렬하기 위해 RGB-D 카메라의 intrinsics와 extrinsics을 사용한다. 그런다음 예측된 물체의 mask를 적용하여 감지된 물체의 3D point cloud Pm을 획득한다. 또한 NOCS mapdmf 사용하여 Pn의 3D representation을 얻는다. 그런다음 Pn을 Pm으로 변환하는 scales,rotation, translation 행렬을 예측한다. 여기서는 7 dimensional rigid transformation 예측문제를 위해 Umeyama 알고리즘을 사용했다고 한다.

예측한 결과는 다음과 같다.

아직 Category level 수준의 6D pose Estimation이 필드에서 많이 쓰이지는 않지만 결국에 CAD 모델 매칭방식의 한계점을 돌파하기 위해서는 이러한 연구가 꾸준히 진행되어야 된다고 생각한다.